پژوهشی در سال 2018 منتشر شد که الگوریتمهایی را آموزش داده بود تا چهره مردم اویغور، اقلیتی در چین که اکثرا مسلمان هستند، را از قومیت کرهای و تبتی تشخیص دهد. در سپتامبر 2019، چهار محقق با احترام کامل خواستار این بودند که فورا انجام این مقاله علمی را متوقف کنند. این عمل به دلیل استفاده غیراخلاقی و بدون رضایت افراد از استفاده از سیستم چهرهشناسی است، در ادامه با آیتیرسان همراه باشید.

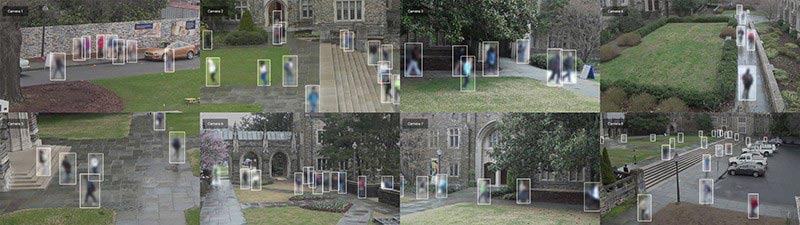

چین قبلا به دلیل نظارت سنگین و بازداشتهای گستردهای از اویغورها در اردوگاههای استان شین جیانگ در شمال غربی چین که به گفته دولت مراکز آموزشی با هدف سرکوب جنبش تروریستی هستند، در سطح بینالمللی محکوم شده بود. طبق گزارش رسانهها، مقامات در سین کیانگ از دوربینهای نظارتی مجهز به نرمافزاری متناسب با چهرههای اویغور استفاده کردهاند.

در نتیجه، بسیاری از محققان این نکته را بسیار ناراحتکننده دانستند که دانشگاهیان برای ساخت چنین الگوریتمهایی تلاش کرده است و ژورنالی آمریکایی نیز مقاله تحقیقاتی خود را در این زمینه منتشر کرده است. پژوهش سال 2018 تنها مطالعه در این زمینه نبود: مجلات ناشران از جمله Springer Nature و موسسه مهندسین برق و الکترونیک نیز مقالاتی با چنین بررسیها منتشر کردهاند که توصیف استفاده از تشخیص چهره برای شناسایی اویغورها و اعضای سایر گروههای اقلیت چینی را نشان میدهد.

این شکایت برای تحقیقات در حال انجام، یکی از تلاشهای فزایندهای است که برخی از دانشمندان و فعالان حقوق بشر برای جلب نظر جامعه علمی در برابر موضع قاطعتر تحقیقات غیراخلاقی تشخیص چهره انجام داده بود. متهم کردن افراد برای استفاده غیراخلاقی از این فناوری بسیار مهم است، اما اخلاقشناسان میگویند این کافی نیست. دانشمندان همچنین باید مبانی اخلاقی مشکوک بسیاری از کارهای دانشگاهی را در این زمینه تأیید کنند، از جمله مطالعاتی که مجموعه دادههای عظیمی از تصاویر چهره افراد را بدون رضایت جمعآوری کرده است. بسیاری از آنها به الگوریتمهای نظارت تجاری یا نظامی کمک میکنند.

تعداد زیادی از دانشمندان از محققان میخواهند که از کار با شرکتها یا دانشگاههای مرتبط با پروژههای غیراخلاقی پرهیز کنند، نحوه جمعآوری و توزیع مجموعه دادههای تشخیص چهره را دوباره ارزیابی کنند و در مورد اصول اخلاقی مطالعات خود تجدید نظر کنند. برخی از موسسات اکنون نیز در حال قدم برداشتن در این راستا هستند. در یک سال گذشته، چندین مجله و یک کنفرانس آکادمیک اعلام کردهاند که قواعد اخلاقی بیشتری در مورد این مطالعات به کار گرفته شده است.

دبورا راجی (Deborah Raji)، محققی در اتاوا که در مرکز اینترنت موزیلا کار میکند، اینچنین میگوید:

اکنون بسیاری از مردم این سوال را از خود میپرسند که وقتی انجام چنین کارهایی غیراخلاقی است، چرا مراکز و جامعه رایانهای انرژی زیادی را صرف کارهای تشخیص چهره میکنند؟ من جمعیتی را میبینم که علیه کل این اقدامات برخاستهاند.

خبرگزاری نیچر از 480 محقق در سراسر جهان که در زمینه شناسایی چهره و هوش مصنوعی فعالیت میکنند، خواسته است تا نظرات خود را در مورد سوالات اخلاقی تحقیقات تشخیص چهره بیان کنند. نتایج این نظرسنجی برای اولین بار نشان میدهد که برخی از دانشمندان نگران اصول اخلاقی کار در این زمینه هستند، اما برخی دیگر هنوز مطالعات آکادمیک را مشکل ساز نمیدانند.

جمعآوری دادهها بدون رضایت افراد

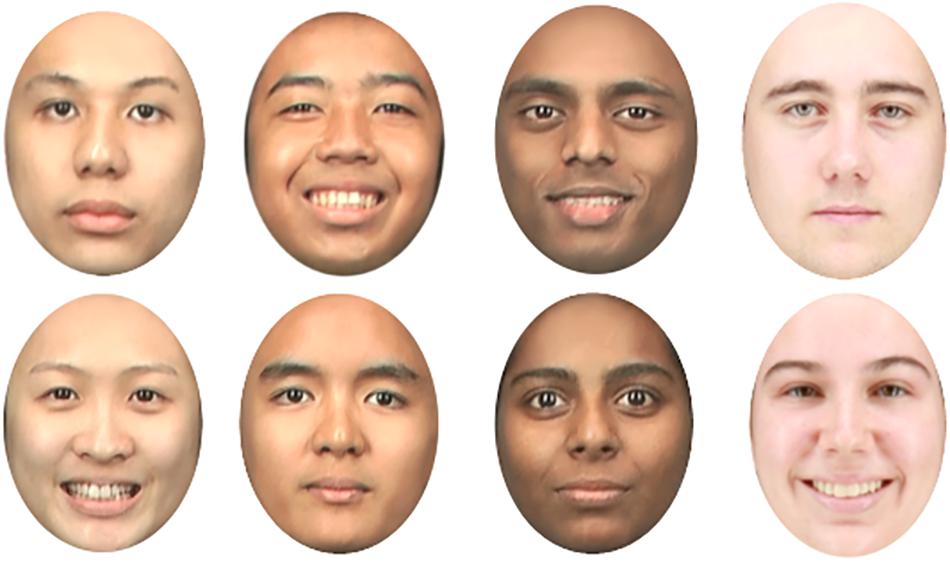

برای اینکه الگوریتمهای تشخیص چهره به خوبی کار کنند، باید آنها را بر روی مجموعه دادههای بزرگ تصاویر گذاشته و آزمایش کرد که در شرایط نوری مختلف و در زوایای مختلف بارها و بارها ثبت میشوند. در دهه 1990 و 2000، دانشمندان به طور کلی داوطلبان را مجبور به ژست گرفتن برای این عکسها میکردند، اما اکثر آنها اکنون تصاویر چهره را بدون درخواست اجازه و رضایت افراد جمعآوری میکنند.

به عنوان مثال، در سال 2015 دانشمندان دانشگاه استنفورد در کالیفرنیا مجموعهای متشکل از دوازده هزار تصویر را از وبکم یک کافه سانفرانسیسکو منتشر کردند که به صورت آنلاین پخش مستقیم میشد. سال بعد، محققان دانشگاه دوک در دورهام، کارولینای شمالی، بیش از 2 میلیون فریم ویدئویی (85 دقیقهای) از تصاویر دانشجویان در حال قدم زدن در محوطه دانشگاه را منتشر کردند.

بزرگترین مجموعههای این دادهها به صورت آنلاین جمعآوری شده بودند. در سال 2016، محققان دانشگاه واشنگتن در سیاتل 3.3 میلیون عکس از سایت اشتراک تصاویر Flickr را از پایگاه دادهای به نام MegaFace منتشر کردند. دانشمندان در تحقیقات مایکروسافت در ردموند، واشنگتن، بزرگترین مجموعه داده جهان (MSCeleb5)، متشکل از 10 میلیون تصویر از تقریباً صدهزار فرد را از جمله روزنامهنگاران، موسیقیدانان و دانشگاهیان را که در اینترنت به طور موقتی حذف شده بود را است منتشر کردند.

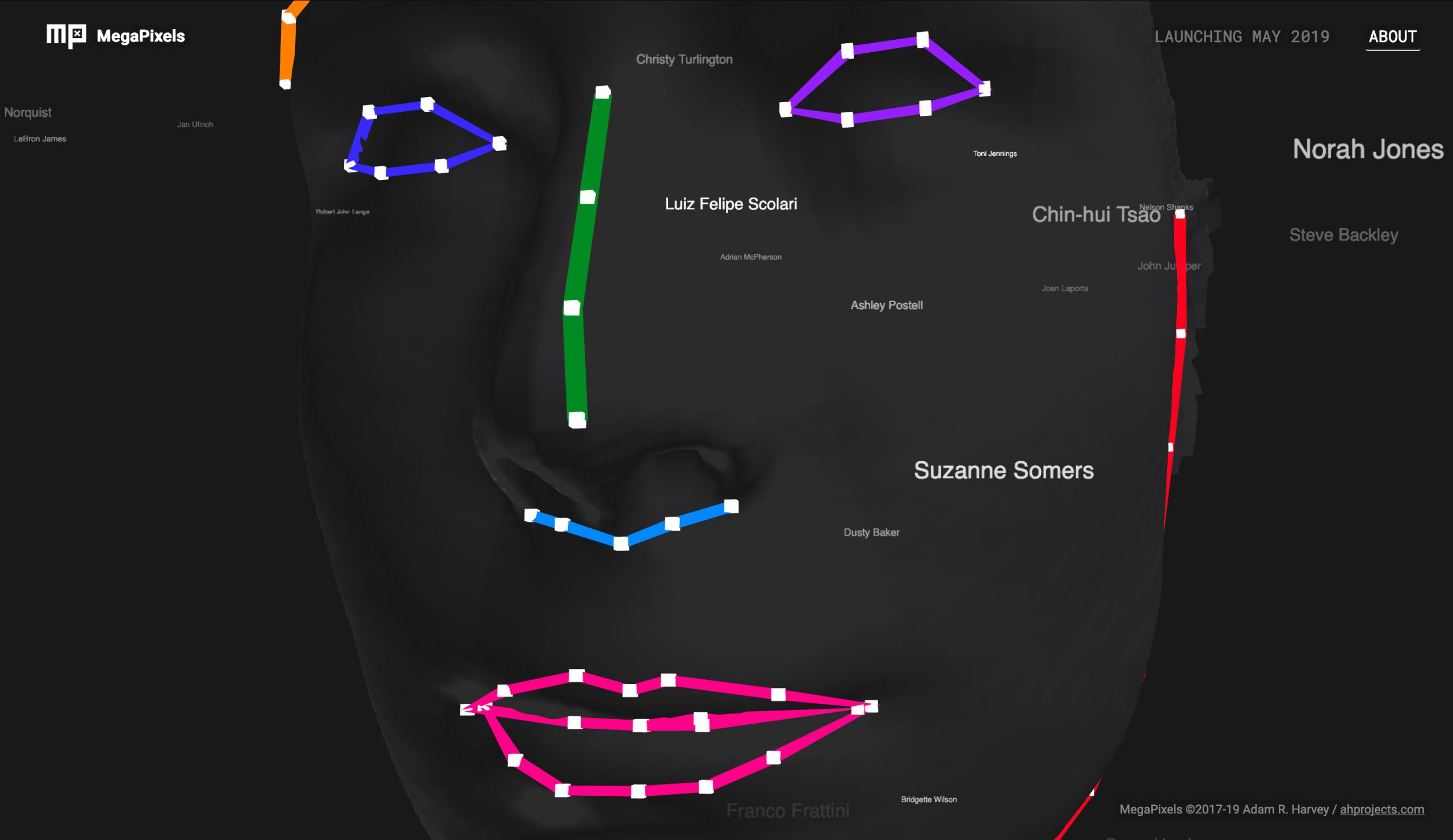

در سال 2019، آدام هاروی (Adam Harvey)، هنرمند اهل برلین، وب سایتی به نام MegaPixels ایجاد کرد که این مجموعه و سایر مجموعه دادهها را نشان میداد. او به همراه ژولز لاپلاس (Jules LaPlace)، تکنسین و برنامهریز مستقر در برلین، نشان دادند که بسیاری از این تصاویر به طور آشکار به اشتراک گذاشته شده و برای ارزیابی و بهبود محصولات نظارت تجاری استفاده شده است. بعضی از آنها توسط شرکتهایی که در پروژههای نظامی در چین کار میکردند مورد استناد قرار گرفت.

هاروی اینچنین میگوید:

میخواستم این حقیقت ناراحتکننده را که بسیاری از عکسهایی که افراد به صورت آنلاین منتشر میکنند، به عنوان دادههای آموزشی پس از مرگشان کشف کنم.

در کل، او گفته است که بیست و نه مجموعه داده را ترسیم کرده است که در حدود 900 پروژه تحقیقاتی استفاده شده است. محققان غالبا از تصاویر عمومی سایت فلیکر استفاده میکنند که تحت مجوزهای حق چاپ مجدد برای استفاده لیبرال بارگذاری شدهاند.

پس از انتشار مقالهای در سایت فایننشال تایمز درباره کار هاروی در سال 2019، مایکروسافت و چندین دانشگاه مجموعه دادههای خود را حذف کردند. بیشتر این افراد و سایتها در آن زمان گفتند که پروژههای آنها به پایان رسیده است یا محققان درخواست کردهاند که مجموعه دادهها حذف شود. کارلو توماسی (Carlo Tomasi)، دانشمند علم کامپیوتر، از دانشگاه دوک، تنها محققی بود که برای اشتباه خود عذرخواهی کرد. او در بیانیهای دو ماه پس از حذف مجموعه دادهها، گفت که برای ضبطهای حرکت اشیا در فیلم و نه برای تشخیص چهره، تأیید هیئت بررسی نهادی را دریافت کرده است. اما راهنمایی هیئت بررسی نهادی گفته است که او نباید در خارج از خانه به ضبط بپردازد و همچنین نباید دادهها را بدون حفاظت از رمز عبور در دسترس همگان قرار میداد. توماسی به خبرگزاری نیچر اینچنین گفت که تلاش کرده است تا با قرار دادن پوسترهایی برای توصیف پروژه، دانشجویان را از این عمل آگاه کند.

طبق سخنان هاروی، حذف مجموعه دادهها استفاده از آنها را کمی کاهش داده است. اما مجموعههای بزرگ تصویر آنلاین مانند MSCeleb هنوز بین محققان توزیع میشود؛ محققان همچنان به این تصاویر استناد میکنند و در برخی موارد آنها یا مجموعه دادههای گرفته شده از آنها را دوباره بارگذاری میکنند. برخی از دانشمندان شرط میکنند که مجموعه دادهها فقط باید برای تحقیقات غیر تجاری مورد استفاده قرار گیرند، اما به محض توزیع گسترده آنها، جلوگیری از دستیابی و استفاده از شرکتها غیرممکن است.

در مهرماه (اکتبر)، دانشمندان کامپیوتر در دانشگاه پرینستون در نیوجرسی گزارش دادند که از 135 مقاله مجموعه دادههای دوک استفاده کردهاند یا دادههای حاصل از آن را چاپ کردهاند. این نویسندگان از محققان خواستند محدودیتهای بیشتری در استفاده از مجموعه دادهها ایجاد کنند و از مجلات خواستند مقالات دیگری را که از مجموعه دادههای حذف شده استفاده میکنند، متوقف کنند.

از نظر قانونی اگر بخواهیم بررسی کنیم، مشخص نیست که آیا دانشمندان در اروپا میتوانند عکسهای صورت افراد را بدون رضایت آنها برای تحقیقات بیومتریک جمعآوری کنند یا خیر. کاترین جاسراند (Catherine Jasserand)، محقق حقوق بیومتریک و حقوق خصوصی در دانشگاه کاتولیک لوون در بلژیک، در سال 2018 گزارش داد که مقررات عمومی حفاظت از دادههای اتحادیه اروپا، قانونی برای محققان در این مورد در نظر نمیگیرد. اما هیچ راهنمای رسمی در مورد چگونگی تفسیر مقررات محافظت از دادههای عمومی در این مورد وجود نداشته است و در دادگاهها آزمایش نشده است. در ایالات متحده، برخی از ایالات میگویند استفاده از دادههای بیومتریک شخص بدون رضایت آنها در شرکتهای تجاری غیرقانونی است. ایالت ایلینوی به افراد اجازه میدهد تا در صورت رخ دادن چنین مواردی در دادگاهها شکایت کنند، که بسیار این حالت بینظیر است. در نتیجه، چندین شرکت با چنین شکایاتی از مردم آسیب دیدهاند.

به عنوان مثال، شرکت رسانههای اجتماعی ایالات متحده فیسبوک، امسال موافقت کرد که 650 میلیون دلار برای حل و فصل شکایات ایالت ایلینوی در مورد مجموعه عکسهایی که در دسترس عموم نبوده است اما برای شناسایی چهره استفاده میشده است، پرداخت کند (اکنون فیسبوک به کاربران امکان میدهد از تگ کردن تشخیص چهره خودداری کنند). مدیر شرکت بحثبرانگیز مستقر در شهر نیویورک Clearview AI که میگوید سه میلیارد عکس آنلاین را برای سیستم شناسایی چهره استفاده کرده است، نیز به دلیل نقض این قانون در دادگاهها به سر میبرد. همچنین از شرکتهای فناوری آیبیام، گوگل، مایکروسافت، آمازون و فیسفرست ایالات متحده نیز به دلیل استفاده از مجموعه دادهای نزدیک به یک میلیون عکس آنلاین که آیبیام در ژانویه 2019 منتشر کرد، در ایالت ایلینوی شکایت شده است. آیبیام عکسها را تقریبا در زمان دادخواست به دنبال ارائه گزارشی از انبیسی نیوز به دلیل نارضایتی عکاسان از وجود تصاویر آنها در مجموعه دادهها حذف کرد.

مایکروسافت به خبرگزاری گفته است که برای رد پرونده، شکایت کرده است و Clearview نیز گفته است که فقط از اطلاعات موجود در دسترس عموم، مانند گوگل یا هر موتور جستجو دیگر استفاده میکند. سایر شرکتها نیز به درخواست برای اظهار نظر پاسخ ندادند.

مردم آسیبپذیر

در بررسیهای چهرههای اویغور که توسط سایت Wiley منتشر شده است، محققان از اینترنت عکس جمع نکرده بودند، اما گفتند که آنها از بیش از 300 دانشجوی 18 تا 22 ساله اویغوری، کرهای و تبتی را در دانشگاه دالیان مینزو در شمال شرقی چین که برخی از دانشمندان در آنجا کار میکردند، عکسهایی گرفتهاند. ماهها پس از انتشار این مطالعه، نویسندگان یادداشتی را اضافه کردند که باعث میشد دانشجویان با این امر موافقت کنند و همین نیز اتفاق افتاد. اما اظهارات محققان نگرانیهای اخلاقی را برطرف نمیکند. ایو مورو (Yves Moreau)، زیست شناس محاسباتی در دانشگاه کاتولیک لوون به همراه گروه مدافع تورنتو به ویلی درخواستی فرستاد تا از انجام پژوهش سال گذشته دست بکشد.

مورو اینچنین اظهار کرده است که بعید به نظر میرسد که به دانشجویان به اندازه کافی در مورد هدف تحقیق گفته شده باشد تا رضایت واقعی آنها بتواند جلب شود. وی اظهار داشت حتی اگر آنها رضایت آزادانه داشته باشند، نقض حقوق بشر در سین کیانگ به این معنی است که ویلی برای جلوگیری از اعتبار علمی اثر، باید پژوهش را متوقف کند.

مورو دهها مقاله در مورد جمعیت اویغورها فهرستبندی کرده است که از جمله آنها میتوان به کارهای شناسایی چهره و پژوهشاتی برای جمعآوری DNA اویغوریها اشاره کرد. در ماه دسامبر، او مقالهای را در خبرگزاری نیچر نوشت و خواستار موقف شدن همه کارهای غیراخلاقی در تحقیقات بیومتریک شد.

اعتراضات او در این بین تاثیراتی داشته است، اما کاملا در حدی نبود که او امیدوار بود باشد. ناشران میگویند مسئله اصلی بررسی این است که آیا شرکتکنندگان در مطالعات آگاهانه رضایت دادهاند یا خیر. به عنوان مثال سایت اسپرینگر نیچر در دسامبر 2019 گفت که مقالههای مربوط به گروههای آسیب پذیر در این زمینه را بررسی میکند و راهنمایی خود را در مورد نیاز به کسب رضایت صریح و آگاهانه در مطالعاتی که شامل دادههای بالینی، زیست پزشکی یا بیومتریک از مردم است، به سردبیران و نویسندگان میرساند. امسال ناشر دو مقاله پژوهش خود در مورد تعیین توالیDNA را پس گرفت، زیرا نویسندگان اعتراف کردند که آنها از مردم اویغور رضایت نخواستهاند و این باعث نگرانی سردبیران 28 مقاله دیگر شده است.

ویلی همچنین بر رضایت آگاهانه افراد تمرکز کرده است. در ماه نوامبر گذشته، ناشر به سایت Moreau and Tech Inquiry اینچنین گفت که فرم رضایتنامه و تأییدیه دانشگاه برای پژوهش دالیان در دسترس است و بنابراین به پژوهش خود ادامه داد چون احساس میکرد میتواند قاطعانه از اقدامات در جین شیانگ جدا شود.

ویلی اینچنین گفته است:

ما از آزار و اذیتهایی که در جوامع اویغور اعمال میشود، آگاه هستیم. با این حال، این مقاله در مورد یک فناوری خاص است و نه کاربرد آن فناوری.

با این حال، در ماه دسامبر، ناشر تحقیقات رسمی خود را در استرالیا در دانشگاه کورتین در پرت، جایی که یکی از نویسندگان در آن مستقر است، آغاز کرد و نیز درخواست عقب نشینی کرد و گفت موافق است که این اثر از نظر اخلاقی اصلا قابل دفاع نیست. در سال جاری، ویلی یادداشت ناشری را اضافه کرد که میگوید مقاله به نظر میرسد با استانداردهای قابل قبول برای انجام تحقیقات در مورد انسان مطابقت دارد. در ماه سپتامبر، پس از آنکه مورو مطالعات قبلی نویسندگان در زمینه شناسایی چهره در مورد اویغورها را انجام داد و به ناسازگاریهای آشکار در جمعآوری مجموعه دادهها اشاره کرد، ویلی ابراز نگرانی در این مطالعه کرد و گفت که مشخص نیست چه زمانی جمعآوری دادهها انجام شده است.

ناشر به خبرگزاری نیچر اینچنین گفت که اکنون پس از بررسی دقیق، پایان این مسئله را اعلام کرده است، اما همه افراد درگیر راضی نیستند. کریس موران (Chris Moran) نماینده معاون، به این خبرگزاری اینچنین گفته است:

اکنون دانشگاه کرتین معتقد است که مقاله باید پس گرفته شود. دانشگاه هنوز هم در حال بررسی این پژوهش است.

ویلی اظهار کرد که پس از مکالمه با مورو، دستورالعملهای خود را به روز کرد تا مطمئن شود استانداردهای مورد انتظار برای رضایت آگاهانه رعایت شده و در مقالهها به کار رفته شده است. ناشران دیگر میگویند که آنها اصلاحاتی در این باره نیز انجام دادهاند. انجمن مهندسان برق و الکترونیک در ماه سپتامبر سیاستی را تصویب کرد که براساس آن نویسندگان مقالات در مورد تحقیقات مربوط به افراد یا حیوانات باید تأیید کنند که از نظر بررسی محلی معادل آن تأییدیه گرفتهاند. سردبیران مقالات باید تعیین کنند که آیا تحقیقات (در مورد بیومتریک یا سایر زمینهها) شامل موضوعات انسانی باشد یا خیر.

اما مورو گفته است که توجه ناشران به رضایت افراد بسیار محدود است و همچنان باید در مورد اصول اخلاقی گستردهتر موضعگیری کنند. او اینچنین اظهار داشت:

اکنون داریم درباره نقض بزرگی از حقوق بشر بحث میکنیم. در برخی از مواقع، ناشران غربی باید حتما خط قرمزها را رعایت کنند و از محدود آنها جلوتر نروند.

او اظهار میکند که ناشران باید هیئتهای اخلاقی مستقلی را تنظیم کنند که در صورت بروز سوالاتی از این قبیل بتوانند راجع به آنها نظر دهند. (هیچ ناشری تا به حال اقداماتی نکردهاند). کیت کرافورد (Kate Crawford)، مدیر مشترک موسسه AI Now در دانشگاه نیویورک، گفته است که دانشگاهها و محققانی که نقض حقوق بشر را قبول ندارند، میتوانند با کنار گذاشتن ارتباط خود با شرکتهای مشکوک در حوزه فناوری، این کار را انجام دهند.

در سال گذشته، در مورد مشارکت دانشگاهها با شرکتها یا برنامههای تحقیقاتی مرتبط با نظارت گسترده در جین شیانگ، تحقیقات زیادی انجام شده است. به عنوان مثال موسسه فناوری ماساچوست در کمبریج گفته است که پس از آنکه دولت ایالات متحده در اواسط جنگ تجاری با چین این شرکت و سایر شرکتهای چینی هوش مصنوعی مانند Megvii در پکن را به دلیل ادعای مشارکت در نقض حقوق بشر در جین شیانگ در لیست سیاه قرار داد، روابط خود را با شرکت فناوری مستقر در هنگ کنگ، SenseTime، بررسی کرد. در سال 2018، شرکتهای SenseTime و MIT اعلام کردند که کمپینی برای هوش مصنوعی راه انداختهاند. شرکت MIT گفت که SenseTime مقداری مبلغ نامعلوم را بدون هیچ محدودیتی در نحوه استفاده از آن به دانشگاه داده است ولی اکنون دانشگاه آن را پس نمیدهد.

شرکتهای Megvii و SenseTime در لیست سیاه ایالات متحده رقابت میکنند. شرکت SenseTime اظهار کرده است که فناوری آن هرگز برای اهداف غیراخلاقی استفاده نشده است و از طرفی دیگر Megvii بیان کرد که این شرکت از مشتریان خود میخواهد از فناوری یا راهحلهای ما برای اهداف غیرقانونی استفاده نکنند.

کنفرانسهای دانشگاهی نیز بسیار بحثبرانگیز بوده است. کنفرانس چین در زمینه شناخت بیومتریک در سال 2018 در پایتخت جین شیانگ، ارومقی برگزار شد. آنیل جین (Anil Jain)، دانشمندی در حوزه کامپیوتر در دانشگاه ایالتی میشیگان در شرق لنسینگ، در کنفرانس هیئت مشاوران شرکت کرد و برای سخنرانی به آنجا سفر کرد. برخی از محققان هوش مصنوعی، از جمله توبی والش (Toby Walsh) در دانشگاه نیوساوت ولز در سیدنی، استرالیا از آنیل جین انتقاد کردند.

مجله کودا همچنین اشاره کرد که خبرگزاری Springer Nature از این کنفرانس حمایت مالی میکرد. این شرکت گفت که نقشش محدود به انتشار جلسات کنفرانس چین در زمینه شناخت بیومتریک بوده است و پس از اینکه نگرانی در مورد محتوای گذشته ایجاد شده بود، الزامات خود را برای برگزارکنندگان کنفرانس برای مطابقت با سیاستهای تحریریه تقویت کرده است. جین از انتقادی که از او شد، اعتراض کرد و به نیچر گفت که شرکت در کنفرانسها در چین به این معنی نیست که شرکتکنندگان در کنفرانس بینالمللی، مانند او، این خشونتها علیه اقلیتها را نادیده میگیرند. او گفت که رشد در نظارت نباید دلیلی برای محدود کردن تبادلات علمی باشد.

جین در هیئت مشاوره کنفرانس شناخت بیومتریک سال 2020–2021 حضور خواهد داشت. خبرگزاری Springer Nature هنوز در حال انتشار خلاصه مقالات کنفرانس است. کنفرانسهای بینالمللی رایانهای همچنان شرکتهای چینی را تحت حمایت مالی پذیرفتهاند. درست بعد از ورود به لیست سیاه، شرکتهای SenseTime و Megvii اسپانسر کنفرانس بینالمللی 2019 رایانهای شدند و Megvii کنفرانس 2020 شناخت الگوهای رایانهای را تحت حمایت مالی قرار داد. اگرچه پس از برگزاری جلسه، آرم این شرکت از وبسایت کنفرانس حذف شد.

والش بیان میکند:

در کنفرانسها باید از ورود حامیانی که متهم به سواستفاده از حقوق بشر هستند، جلوگیری کنیم.

با این حال، او خاطرنشان کرد که سال گذشته سازمان غیردولتی حامی حقوق بشر در شهر نیویورک ادعاهای اولیه مبنی بر دخالت فناوری شناسایی چهره شرکت Megvii در برنامهای که در جین شیانگ استفاده شده بود را نقض کرد. برگزارکنندگان کنفرانس به درخواستی برای اظهار نظر پاسخ ندادند.

بررسیهای اخلاقی

پروژههای تحقیقاتی مشکوک در ایالات متحده نیز رخ داده است. در تاریخ 5 مه، دانشگاه هریسبورگ در پنسیلوانیا با انتشار بیانیه مطبوعاتی اعلام کرد که محققان در آنجا نرمافزار تشخیص چهره با توانایی 80 درصد دقت و بدون تعصب نژادی را برای شناسایی شخص خاطی، تولید کردهاند. این خبر همانند پژوهشی در قرن نوزدهم در اعتراض به اقدام فیزیولوژیستهای آن دوره موجی از انتقادات را برانگیخت. مطالعهای مشهور در سال 2016 نشان داد که دستگاه تشخیص چهره میتواند تفاوت بین تصاویر افراد غیر جنایتکار و مجرمان محکوم را که توسط اداره پلیس چین تهیه شده است، تشخیص دهد.

دانشگاه هریسبورگ در ششم ماه مه به دنبال آن اعتراض، اطلاعیه مطبوعاتی خود را حذف کرد، اما یک سوال مهم را بیپاسخ باقی گذاشت: در بیانیه مطبوعاتی گفته شده بود که این اثر توسط خبرگزاری Springer Nature در یک مجموعه کتاب منتشر میشود (که ناشر بعدا آن را انکار کرد). در تاریخ 22 ژوئن، بیش از 2400 افراد عضو دانشگاه نامهای از گروهی به نام ائتلاف برای فناوری انتقادی (CCT) را امضا کردند که از خبرگزاری Springer Nature خواسته بود این اثر را منتشر نکند و از همه ناشران خواست تا از انتشار مطالعات مشابه نیز به طور جدی خودداری کنند.

در این نامه اشاره شده است که چنین مطالعاتی مبتنی بر علمی نادرست است. همچنین اشاره کرد که ابزارهای الگوریتمی که به در خدمت پلیس است و میگوید کجا یا چه کسی را هدف قرار دهد، تنها تمایل دارد روشی خودکار در تحقیقات خود پیدا کند تا تعصبات موجود در سیستم عدالت کیفری را تشدید کند. سه روز قبل از آن، بیش از 1400 ریاضیدان آمریکایی نامهای نوشتند که به دلیل نگرانی در مورد نژادپرستی سیستمی در سازمانهای اجرای قانون ایالات متحده، از همکاران خود خواستند که برای جلوگیری از همکاری با پلیس در الگوریتمهایی که ادعا میکنند به کاهش جرم کمک میکنند، دوری کنند.

این خبرگزاری اینچنین گفت که این اثر هرگز برای چاپ پذیرفته نشد، بلکه به کنفرانسی ارسال شده و پس از بررسی همکاران رد شده است (نویسندگان و دانشگاه هریسبورگ از اظهار نظر خودداری کردند).

این خبرگزاری در گذشته نیز به خاطر مقاله دیگری که در ماه ژانویه در مجله Big Data منتشر شده بود، مورد انتقاد قرار گرفته بود. مقاله مذکور درباره تشخیص گرایش جنایی در عکسهای مجرمان و غیر مجرمان بود. پس از اینکه محققان انجمن مهندسان برق و الکترونیک با مرکز اصول اخلاقی تماس گرفتند، مارگرت هال (Margeret Hall)، نویسنده مقاله در دانشگاه نبراسکا اوماها، در ژوئن خواستار پس گرفتن مقاله شد. هال اینچنین اظهار کرده است که مقالهای که اکنون پس گرفته شده است، غیرقابل دفاع بود. خبرگزاری Springer Nature نیز بیان کرده است که این مجله روند خود را بررسی کرده و اکنون از نویسندگان خواسته است هنگام ارسال نوشتهها، بیانیههایی در مورد تأییدیههای اخلاقی و رضایت نامه درج کنند.

پژوهشات خبرگزاری نیچر

این خبرگزاری امسال برای دستیابی به درک وسیعتری از دیدگاههای آموزشی در مورد اصول اخلاقی تشخیص چهره، از 480 محقق که مقالاتی در زمینه شناسایی چهره، هوش مصنوعی و علوم رایانه منتشر کردهاند، نظرسنجی کرد. پاسخدهندگان در مورد برخی سوالات الویتهایی نشان دادند. وقتی از نظرات آنها درباره مطالعاتی که از روشهای تشخیص چهره برای شناسایی یا پیشبینی خصوصیات شخصی (مانند جنسیت، هویت جنسی، سن یا قومیت) از ظاهر استفاده میشود، خواسته شد، حدود دو سوم گفتند که چنین مطالعاتی باید فقط با رضایت آگاهانه از کسانی که از چهره آنها استفاده شده است، انجام شود یا این کار پس از گفتگو با نمایندگان گروههایی که ممکن است تحت تأثیر قرار بگیرند، اعمال شود.

اما در مورد سایر مسائل، دانشگاهیان باهم موافق نبودند. حدود 40 درصد از دانشمندان در این نظرسنجی احساس کردند که محققان باید قبل از استفاده از چهره آنها در مجموعه دادههای تشخیص چهره، رضایت آگاهانه افراد را کسب کنند، اما بیش از نیمی از آنها احساس میکردند که این کار اصلا ضروری نیست. مشل اصلی محققان این است که نمیتوان فهمید که چگونه آنها میتوانند الگوریتم های تشخیص چهره دقیق را بدون مجموعه دادههای گسترده آموزش دهند. سباستین مارسل (Sébastien Marcel)، رهبر گروه بیومتریک در موسسه تحقیقاتی Idiap در Martigny سوئیس فکر میکند که محققان باید رضایت آگاهانه افراد را برای استفاده در تحقیقات چهرهشناسی کسب کنند، اما در عمل، این کار را انجام نمیدهند. گروه او برای یافتن تصاویر از وب استفاده نمیکند، اما از مجموعه دادههای تصویر آنلاین که دیگران گردآوری کردهاند، بهره میبرد. سباستین مارسل اینچنین گفته است:

بسیاری از محققان نمیخواهند در این مورد چیزی بشنوند، چون آنها این مسئله را جزو مشکلات خود نمیدانند.

اد گرستنر (Ed Gerstner)، مدیر سیاسی مجله Springer Nature، گفته است که ناشر در حال بررسی این است که ببیند چه کاری میتواند برای جلوگیری از ادامه استفاده از پایگاه دادههای تصویری که رضایت صریح افراد برای استفاده آنها در تحقیقات وجود ندارد، انجام دهد.

نظرسنجی این خبرگزاری همچنین از محققان سوال کرد که آیا آنها نیز فکر میکنند تحقیقات تشخیص چهره در مورد افراد آسیبپذیر مانند پناهندگان یا گروههای اقلیتی که تحت نظارت شدید بودند، حتی اگر با رضایت آگاهانه نیز بوده باشد، میتواند از نظر اخلاقی سوالبرانگیز باشد یا خیر. به طور کلی، 71 درصد از محققان با این مسئله موافقت کردند. برخی اظهار داشتند که ممکن است جلب رضایت از تمامی جمعیت آسیبپذیر انجام نشده باشد، که تحقیق را خیلی بیارزش میکند.

با این حال، برخی از کسانی که مخالف بودند، سعی کردند بین تحقیقات دانشگاهی و نحوه استفاده از تشخیص چهره تمایز قائل شوند. آنها گفتند که تمرکز باید بر محکوم کردن و محدود کردن کاربردهای غیراخلاقی تشخیص چهره باشد، نه محدود کردن تحقیقات. اخلاقگرایان این تمایز را احمقانه میدانند. کارن لوی (Karen Levy)، جامعه شناس دانشگاه کرنل در ایتاکا، نیویورک، که در زمینه اخلاق فناوری کار میکند، اینچنین اظهار کرده است که ما اکنون از آن گذر کردهایم.

برخی از پاسخدهندگان در چین از این سوال اظهار ناراحتی کردهاند. یکی از این افراد اینچنین گفت:

نباید بگویید که در جین شیانگ برخی گروهها بازداشت میشوند.

کمتر از نیمی از 47 پاسخدهنده چینی احساس کردند که مطالعات در مورد گروههای آسیب پذیر حتی اگر رضایت دانشمندان را جلب کرده باشند، از نظر اخلاقی سوالبرانگیز است. بیشتر از 73 درصد در ایالات متحده و اروپا نیز با این مسئله موافق بودند.

یکی از محققان آمریکایی-چینی هوش مصنوعی گفته است که شکاف فرهنگی در این زمینه وجود دارد. او اینچنین اظهار کرد:

محققان چینی در کنفرانسهای برتر که فعالانه از اردوگاه کار اجباری و سانسورچیهای جین شیانگ حمایت میکنند، به شدت مرا نگران میکند. این گروهها حداقل تماس با رسانههای بدون سانسور دارند و تمایل دارند از کسانی که به زبان ماندارین صحبت نمیکنند، به ویژه در مورد مسائل اجتماعی از این قبیل، خودداری کنند. من معتقدم که باید راههایی برای تعامل فعالانه با این گروه از جامعه پیدا کنیم.

خبرگزاری نیچر از محققان پرسید که جامعه علمی درباره مطالعات مشکوک اخلاقی چه کاری باید انجام دهد. مشهورترین پاسخ این بود که در طول بررسیها، از نویسندگان مقالات تشخیص چهره باید صریحاً در مورد اصول اخلاقی مطالعاتشان سوال شود. در این نظرسنجی همچنین پرسیده شد که آیا تحقیقاتی که از نرمافزار تشخیص چهره استفاده میکنند، نیاز به تأیید قبلی نهادهای اخلاقی مانند کمیته اخلاق که تحقیقاتی با افراد انسانی در ارتباط است، دارد یا خیر. تقریباً نیمی از افراد اظهار کردند که نیاز به تایید نهادهای اخلاقی وجود دارد و یک چهارم دیگر نیز گفتند که این مسئله به نوع تحقیق بستگی دارد.

پیامد اخلاقی

محققانی که روی فناوری شناسایی یا بررسی چهرهها کار میکنند، خاطرنشان میکنند که این فناوری کاربردهای زیادی دارد، مانند یافتن کودکان گمشده، ردیابی مجرمان، دسترسی راحتتر به تلفنهای هوشمند و خودپردازها؛ و این فناوری به رباتها نیز کمک میکند تا با شناخت هویت و احساسات آنها با انسان تعامل داشته باشند و در برخی از مطالعات پزشکی، برای کمک به تشخیص یا ردیابی از راه دور شرکتکنندگان استفاده میشود. جین اینچنین گفته است:

تعدادی از برنامههای قانونی و مجاز شناسایی چهره و بیومتریک وجود دارد که ما در جامعه به آنها نیاز داریم.

اما برخی از دانشمندان میگویند که محققان همچنین باید تشخیص دهند که فناوری که میتواند افراد را از راه دور بدون شناخت آنها شناسایی یا طبقهبندی کند، بسیار خطرناک است و باید سعی کنیم تا از آن برای کنترل یا تشخیص مجرمان استفاده شود.

چلسیا باراباس (Chelsea Barabas)، اینچنین گفته است:

جامعه هوش مصنوعی از دیدن اینکه چگونه خدماتش در تاریخ طولانی علمی برای مشروعیت بخشیدن به خشونت علیه افراد حاشیهساز و طبقهبندی و جدا کردن افراد استفاده میشود، رنج میبرد. اگر شما الگوریتم تشخیص چهرهای تهیه کنید و بدون اینکه فکر کنید که این فناوری برای چه نوع تحقیقات پزشکی توسط مجریان قانون استفاده خواهد شد، میتوان گفت که بسیار سهلانگاری کردهاید.

برخی از سازمانها خواستار احتیاط بیشتر محققان هستند. کنفرانس NeurIPS (سیستمهای پردازش اطلاعات عصبی) یکی از جلسات برتر حوزه هوش مصنوعی است که برای اولین بار در سال جاری به چنین ملاحظات اخلاقی نیاز دارد. دانشمندانی که مقالاتی را ارائه میدهند باید بیانیهای اضافه کنند که نگرانیهای اخلاقی و نتایج احتمالی منفی کار آنها را برطرف کند.

دیوید ها (David Ha)، محقق هوش مصنوعی در گوگل در توکیو اینچنین گفته است:

با این راهحل این مسئله حل نخواهد شد، اما این یک گام در مسیر درست است.

مجله Nature Machine Intelligence همچنین در حال بررسی روشی است که در آن از نویسندگان برخی مقالات میخواهد بیانیهای را با توجه به تأثیرات گسترده جامعه و نگرانیهای اخلاقی درج کنند.

لوی امیدوار است که دانشگاهیان در تحقیقات تشخیص چهره به پیامدهای اقدامات غیراخلاقی خود آگاه شوند و باید مسائل اخلاقی در این زمینه را ریشهیابی کنند. او گفته است:

به نظر میرسد اکنون زمانی است که جامعه علمی باید از خواب غفلت بلند شوند، مردم کاملا آگاه هستند که استفاده از فناوریها ممکن است شکل سیاسی به خود بگیرد و ممکن است خود این مسئله را به طور درونی حس کنند.