اگر دستیارهای صوتی مجازی مثل سیری یا کورتانا را یکی از پیشرفتهترین فناوریهای به کار رفته در نرمافزار اسمارت فونهای نسل حاضر بدانیم، پس به جرات میتوان گفت که در بخش سختافزار، پردازنده هوش مصنوعی در زمره برترین نوآوریهای موجود در این دیوایسها به شمار میرود.

اپل به واسطهی موتور عصبی هوش مصنوعی جدیدی که در چیپ A11 به کار رفته، نام A11 Bionic را برای این چیپ برگزیده است. چیپ جدید Kirin 970 هوآوی مجهز به یک واحد پردازش عصبی یا همان NPU است و بر همین اساس، این شرکت سردمدار جدید خودش یعنی Mate 10 را یک گوشی واقعا هوشمند خطاب میکند. نسل بعدی چیپ اگزینوس سامسونگ هم مطابق شایعات، یک پردازنده هوش مصنوعی مختص به خودش خواهد داشت.

شرکت کوالکام در این زمینه پیشدستی کرده و از چند نسل قبل، در پردازندههای سردمدار اسنپدراگون، پردازشگرهای سیگنالهای دیجیتالی Hexagon را در اختیار محاسبات ناهمگن و SKUهای شبکهی عصبی قرار داده است. از این گذشته، شرکتهایی مثل اینتل، Nvidia و دیگر مهرههای کلیدی فعال در این زمینه مشغول کار کردن بر روی محصولات پردازشگر هوش مصنوعی خودشان هستند. این رقابت همین حالا هم به صورت جدی در حال گسترش است.

دلایل بسیار خوبی برای پدیدار شدن این پردازندههای اضافی در چیپهای گنجانده شده در اسمارت فونهای امروزی وجود دارد. تقاضا برای پردازش همزمان صوت و تشخیص هوشمندانه تصاویر با سرعت سرسامآوری رو به افزایش است. با این حال، مطابق معمول، مهملهای تبلیغاتی فراوانی در این زمینه تبادل میشود که باید به توضیح و توجیه آنها کوشید.

چیپهایی به هوشمندی مغز انسان؟!

شرکتها دوست دارند به ما ثابت کنند که موفق شدهاند و چیپهایی تولید میکنند که به اندازه مغز انسان باهوش هستند و قادرند به خودی خود فکر کنند و تصمیم بگیرند. اما حقیقت این است که پیشرفتهترین پروژههای آزمایشگاهی در این رابطه، حتی به گرد پای این تصور نیز نرسیدهاند. در تبلیغات اسمارت فونها، شرکتها به جد سعی میکنند محصول خود را کامل و بینقص جلوه بدهند، در حالی که همان محصول در واقعیت خیلی معمولیتر از این حرفهاست. طراحی جدید پردازندهها به زبان ساده، میکوشد تا وظایف نرمافزاری خاصی مانند یادگیری ماشین (Machine Learning) را کارآمدتر کند و نه چیزی فراتر از آن.

یک تفاوت مهم بین هوش مصنوعی و یادگیری ماشین وجود دارد که لازم است به آن اشاره شود. هوش مصنوعی در اصل یک مفهوم بسیار گسترده برای توصیف ماشینهایی است که میتوانند “مثل انسانها” فکر کنند یا به یک نوع مغز مصنوعی مجهز هستند که تواناییهای مشابه با مغز خودمان دارد.

یادگیری ماشین هم از این بحث خارج نیست، اما هدف از یادگیری ماشین اساسا انباشتن برنامههای کامپیوتری طراحی شده برای پردازش دادهها و تصمیمگیری بر مبنای نتایج این پردازش و حتی یاد گرفتن از این نتایج برای تصمیمگیری بهتر در آینده است.

از سوی دیگر، شبکههای عصبی مجموعهای از سیستمهای کامپیوتری هستند که ماموریتشان کمک به برنامههای یادگیری ماشین در دستهبندی دادهها و قدرت بخشیدن به کامپیوترها برای مرتب کردن دادهها به طرقی مشابه سبک و سیاق تصمیمگیری انسانها است. این میتواند شامل پردازشهایی مثل حذف کردن برچسبها از عکسها یا تشخیص رنگها نیز بشود. شبکههای عصبی و یادگیری ماشین هر دو هوشمند هستند، اما قطعا نه در حد و اندازه ما انسانها.

وقتی حرف از هوش مصنوعی به میان میآید، بنگاههای تبلیغاتی به شکلی از آن سخن میگویند که توضیح منطقی آن را دشوار میکند. در هر حال، آنچه تمامی این شرکتها در آن مشترک هستند این است که به بیان ساده، همه آنها مشغول به کار گیری یک بخش جدید در چیپهای خودشان هستند؛ بخشی که میتواند کارایی و بهرهوری وظایفی که ما امروزه با عباراتی همچون “هوشمند” یا “دستیارهای مجازی هوش مصنوعی” میشناسیم بهبود ببخشد. این بهسازیها عموما در حیطههایی مثل تشخیص صوت و تصویر خودنمایی میکنند، ولی زمینههای دیگری هم در این مورد قابل اشاره هستند.

انواع جدیدی از محاسبات

شاید بزرگترین سوالی که هنوز به آن پاسخ ندادیم این باشد که چرا شرکتها ناگهان تصمیم گرفتهاند که این اجزا را به چیپهای خود اضافه کنند؟ این اجزای جدید در واقع چه کارهایی را برای کاربر سادهتر میکنند؟ اصلا چرا حالا باید زمان این تغییرات باشد؟

ممکن است به تازگی متوجه افزایش حرف و حدیثها در مورد شبکههای عصبی، یادگیری ماشین و محاسبه ناهمگن شده باشید. همه اینها در واقع به گسترش میزان استفاده کاربران از اسمارت فونها وابسته است، و حجم وسیعی از زمینهها را شامل میشود. این فناوریها سعی دارند تا از طریق بهبود پردازش صوت و تصویر، پیشبینی رفتارهای انسانی، پردازش زبان و گفتار، سرعت بخشیدن به نتایج جستوجو بانکهای اطلاعاتی و رمزگذاری پیچیدهتر اطلاعات، یک نوع تجربه کاربری جدیدتر و بهتر را برای کاربران به ارمغان بیاورند.

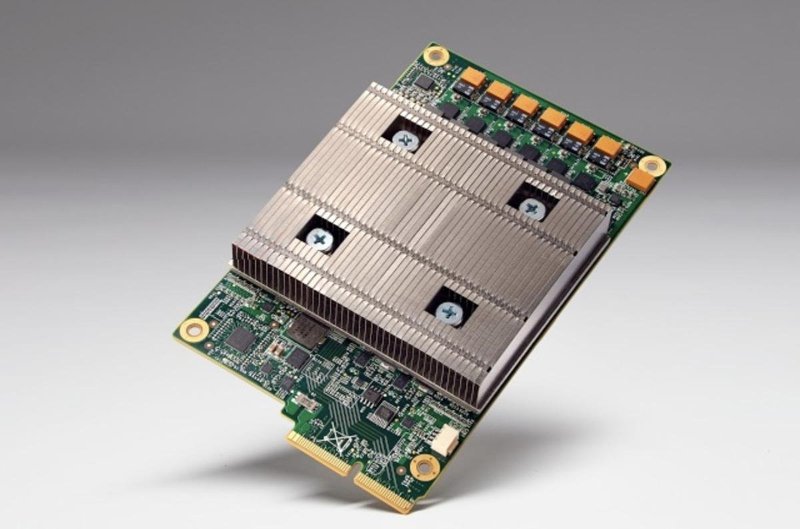

یکی دیگر از پرسشهایی که همچنان بیپاسخ مانده این است که محاسبه این نتایج در فضای ابری بهتر است یا در خود دیوایس و به صورت لوکال؟ فارغ از اینکه شرکتها هرکدام چه پیشنهادی در این رابطه دارند، پاسخ این سوال معمولا به وظیفهای بستگی دارد که در حال محاسبه است. در هر حال، چنین محاسباتی اغلب به نگرشهای جدید و پیچیدهای به کامپیوترها نیاز دارد؛ نگرشهایی که اکثر CPUهای ۶۴ بیتی امروزی به اندازه کافی برای تحلیلشان مناسب نیستند. ریاضیات ممیز شناور ۸ و ۱۶ بیتی، تطبیق الگو، جستوجوی مرکز داده/گذرواژه، دستکاری بیت فیلدها و پردازشهای فوق موازی فقط نمونههایی از عملیاتی هستند که انجام آنها به وسیله سختافزارهای مخصوص آسانتر از CPUهایی با کاربری عمومی است.

برای وفق یافتن با رشد این زمینههای جدید، طراحی پردازندههای شخصیسازی شده جدید منطقیتر از استفاده کردن از سختافزارهای ضعیف قدیمی است. علاوه بر این، چیپهای جدید مسلما در آینده هم بهتر به کار خواهند آمد. افزودن یک پردازنده هوش مصنوعی از همین ابتدای نسل هوشهای مصنوعی، به توسعهدهندگان این فرصت را میدهد که خودشان را برای یک انقلاب در عرصهی نرمافزارها آماده کنند.

بهرهوری کلید توسعه است

شایان ذکر است که هدف این چیپهای جدید صرفا ارائه قدرت محاسبه بیشتر نیست. هدف دیگرشان افزایش بهرهوری در سه محدوده اساسی است: اندازه، محاسبات و انرژی.

چیپهای سردمدار نسل امروز از اجزای متعددی تشکیل شدهاند، از درایورهای صفحه نمایشها گرفته تا مودمها. این اجزا باید در یک سطح بسیار اندک جای بگیرند و از یک منبع نیروی محدود تغذیه شوند. طراحان چیپها وقتی میخواهند قابلیتهای جدیدی برای پردازش شبکههای عصبی به سیستم اضافه کنند، باید به تمامی این محدودیتها نیز توجه نمایند.

طراحان چیپهای اسمارت فونها این امکان را دارند که هستههای CPU را بزرگتر و قدرتمندتر بسازند تا راحتتر بتوانند وظایف یادگیری ماشین را هدایت کنند. اما از سوی دیگر، این اقدام منجر به افزایش قابل توجه سایز هستهها میشود که در نتیجه هزینه تولید چیپها نیز چند برابر میشود. ضمنا مقدار نیروی مصرفی چیپها هم در این حالت به شدت زیاد میشود و این برای اسمارت فونهایی با قدرت طراحی حرارتی ۵ وات شرایط خوبی را فراهم نمیکند.

در عوض، عاقلانهتر این است که یک جز واحد جداگانه برای این منظور طراحی گردد؛ جزئی که بتواند مجموعهای خاص از وظایف را به صورت موثر هدایت نماید. این اتفاق در جریان توسعه پردازندهها به کرات دیده شده است: از واحدهای ممیز شناور اختیاری در CPUهای اولیه تا پردازندههای سیگنالهای دیجیتال Hexagon در چیپهای سردمدار شرکت کوالکام. پردازندههای سیگنالهای دیجیتال در طول سالیان اخیر در زمینههای صوت و خودرو و بازارهای دیگر بارها شاهد سقوط و صعودهای متعدد بودهاند که اغلب از کشمکشهای بین قدرت محاسبه در برابر بهرهوری قدرت و هزینه نشات میگرفتهاند. ملزومات نیروی کم و دادههای سنگین در یادگیری ماشین در دنیای موبایلها، در حال حاضر عامل اصلی زنده نگه داشتن تقاضای این بازار است.

نتیجهگیری

این بدبینی نیست اگر بخواهیم بپرسیم که شرکتها چه زمانی در مورد نمایش خود از شبکههای عصبی و پردازندههای هوش مصنوعی کاملا دقیق و صادق هستند. شاید پاسخ این سوال به راحتی پیدا نشود، ولی آنچه مسلم است این است که افزودن یک پردازشگر مجزا برای محاسبه ریاضیات پیچیده و ساختن الگوریتمهای طبقهبندی دادهها قطعا به اسمارت فونها و دیگر محصولات جهان تکنولوژی، کمک میکند که باهوشتر بشوند و در پروسههایی مثل بهبود خودکار کیفیت عکسها یا جستوجوی سریعتر مجموعه ویدیوها بهتر عمل کنند.

در آخر، هر چقدر هم که شرکتها در مورد دستیارهای مجازی و پردازندههای هوش مصنوعی خود بزرگنمایی کنند، مطمئن باشید که هیچ وقت (حداقل نه در آیندهی نزدیک) اسمارت فونها به اندازه خود شما باهوش نخواهند شد. ولی با این اوصاف، همه این فناوریهای جدید در ترکیب با ابزارهای در حال ظهور یادگیری ماشین، اسمارت فونهای ما را مسلما مفیدتر از قبل خواهند کرد. پس دنبال کردن رویدادهای این عرصه میتواند مهم تلقی شود.

الان تو دنیای تکنولوژی دیگ همه چی رو دارن مجهز ب هوش مصنوعی میکنن همشون باهم رقابت دارن ..اسمارت فون ها هم ک اصلی کاری ان حتما باید داشته باشن

کاملا درسته